A Supermicro lançou um novo conjunto de soluções para avançar na implantação de IA generativa, marcando um passo significativo na evolução da infraestrutura para grandes modelos de linguagem (LLMs). Essas soluções SuperCluster são projetadas como componentes essenciais para dar suporte às demandas atuais e futuras de IA.

A Supermicro lançou um novo conjunto de soluções para avançar na implantação de IA generativa, marcando um passo significativo na evolução da infraestrutura para grandes modelos de linguagem (LLMs). Essas soluções SuperCluster são projetadas como componentes essenciais para dar suporte às demandas atuais e futuras de IA.

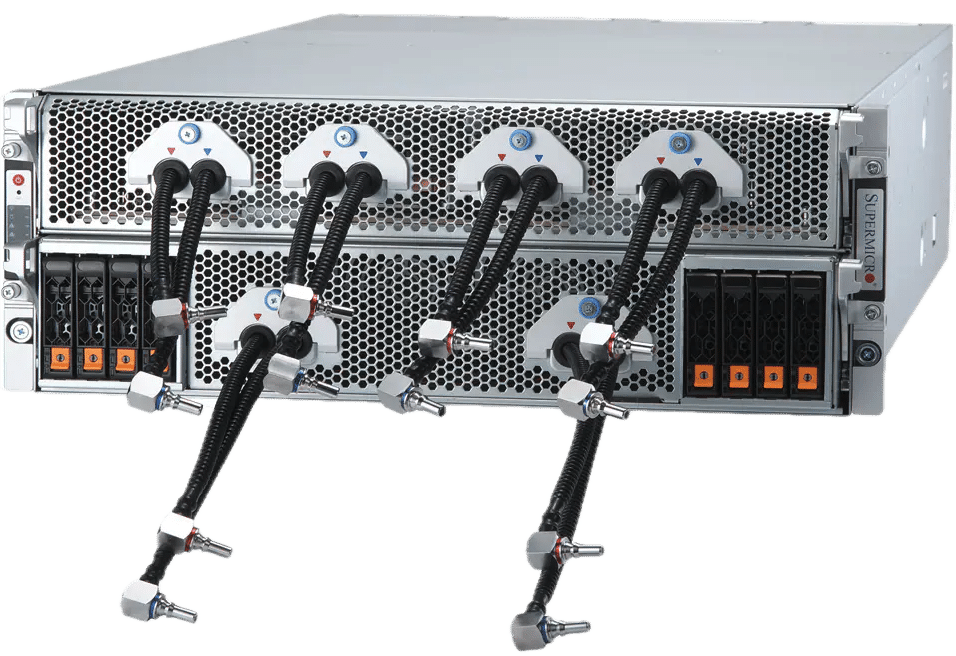

Esta nova versão inclui três configurações distintas do SuperCluster adaptadas para tarefas generativas de IA. As opções incluem um sistema 4U refrigerado a líquido e uma configuração 8U refrigerada a ar projetada para treinamento LLM intensivo e inferência LLM de alta capacidade. Além disso, uma variante 1U refrigerada a ar com sistemas NVIDIA MGX da Supermicro é voltada para aplicações de inferência em escala de nuvem. Esses sistemas são construídos para oferecer desempenho incomparável em treinamento LLM, apresentando recursos como lotes grandes e recursos substanciais de manipulação de volumes para inferência LLM.

Expansão da capacidade para clusters de IA

Com a capacidade de produzir até 5,000 racks por mês, a Supermicro está posicionada para fornecer rapidamente clusters generativos completos de IA, prometendo velocidades de entrega mais rápidas aos seus clientes. Um cluster de 64 nós, por exemplo, pode incorporar 512 GPUs NVIDIA HGX H200, utilizando redes NVIDIA Quantum-2 InfiniBand e Spectrum-X Ethernet de alta velocidade para obter um ambiente robusto de treinamento de IA. Em conjunto com o software NVIDIA AI Enterprise, esta configuração é uma solução ideal para infraestruturas empresariais e em nuvem que visam treinar LLMs sofisticados com trilhões de parâmetros.

Inovando resfriamento e desempenho

Os novos sistemas 4U NVIDIA HGX H100/H200 de 8 GPUs da Supermicro aproveitam o resfriamento líquido para dobrar a densidade em comparação com as alternativas 8U refrigeradas a ar, resultando em menor consumo de energia e uma diminuição no custo total de propriedade para data centers. Esses sistemas suportam GPUs de próxima geração baseadas na arquitetura NVIDIA Blackwell, apresentando tecnologias de resfriamento eficientes que mantêm temperaturas ideais para desempenho máximo.

Especificações do SuperCluster

Os SuperClusters da Supermicro são soluções escaláveis para treinar modelos de base massivos e criar infraestruturas de inferência LLM em escala de nuvem. Com uma arquitetura de rede altamente escalável, esses sistemas podem expandir de 32 para milhares de nós, garantindo escalabilidade contínua. A integração de refrigeração líquida avançada e processos de testes abrangentes garante eficiência e eficácia operacional.

A Supermicro detalha duas configurações principais: o SuperCluster com sistema 4U refrigerado a líquido, capaz de suportar até 512 GPUs em um espaço compacto, e o SuperCluster com sistema NVIDIA MGX refrigerado a ar 1U, projetado para tarefas de inferência de alto volume e baixa latência . Ambas as configurações se destacam pelo alto desempenho de rede, essencial para treinamento e inferência LLM.

Aqui está um rápido resumo de suas especificações:

SuperCluster com sistema 4U refrigerado a líquido em 5 racks ou sistema 8U refrigerado a ar em 9 racks

- 256 GPUs NVIDIA H100/H200 Tensor Core em uma unidade escalável

- Resfriamento líquido permitindo 512 GPUs, 64 nós, no mesmo espaço que a solução de 256 GPUs, 32 nós refrigerada a ar

- 20 TB de HBM3 com NVIDIA H100 ou 36 TB de HBM3e com NVIDIA H200 em uma unidade escalável

- A rede 1:1 oferece até 400 Gbps para cada GPU para permitir RDMA e armazenamento GPUDirect para treinar modelos de linguagem grandes com até trilhões de parâmetros

- Estruturas de switch Ethernet 400G InfiniBand ou 400GbE com topologia de rede spin-leaf altamente escalável, incluindo NVIDIA Quantum-2 InfiniBand e NVIDIA Spectrum-X Ethernet Platform.

- Estrutura personalizável de armazenamento de pipeline de dados de IA com opções de sistema de arquivos paralelos líderes do setor

- Software NVIDIA AI Enterprise 5.0, que traz suporte para novos microsserviços de inferência NVIDIA NIM que aceleram a implantação de modelos de IA em escala

SuperCluster com sistema NVIDIA MGX refrigerado a ar de 1U em 9 racks

- 256 Superchips GH200 Grace Hopper em uma unidade escalável

- Até 144 GB de HBM3e + 480 GB de memória unificada LPDDR5X adequada para inferência em escala de nuvem, alto volume, baixa latência e alto tamanho de lote, capaz de ajustar um modelo de parâmetro de 70B+ em um nó.

- Estruturas de switch Ethernet 400G InfiniBand ou 400G com topologia de rede Spine-Leaf altamente escalável

- Até 8 dispositivos de armazenamento E1.S NVMe integrados por nó

- Estrutura de armazenamento de pipeline de dados de IA personalizável com DPUs NVIDIA BlueField-3 e opções de sistema de arquivos paralelos líderes do setor para fornecer acesso de armazenamento de alto rendimento e baixa latência para cada GPU

- Software NVIDIA AI Enterprise 5.0

Supermicro expande portfólio de IA com novos sistemas e racks usando arquitetura NVIDIA Blackwell

A Supermicro também está anunciando a expansão de suas ofertas de sistemas de IA, incluindo as mais recentes inovações em data centers da NVIDIA voltadas para IA generativa em grande escala. Entre essas novas tecnologias estão o NVIDIA GB200 Grace Blackwell Superchip e as GPUs B200 e B100 Tensor Core.

Para acomodar esses avanços, a Supermicro está atualizando continuamente seus sistemas existentes NVIDIA HGXH100/H200 Sistemas de 8 GPU para integrar NVIDIA HGX B100 8-GPU e B200. Além disso, a linha NVIDIA HGX será reforçada com os novos modelos apresentando o NVIDIA GB200, incluindo uma solução abrangente em nível de rack equipada com 72 GPUs NVIDIA Blackwell. Além desses avanços, a Supermicro está lançando um novo sistema de refrigeração líquida NVIDIA HGX B4 de 200 GPUs em 8U, aproveitando a tecnologia de refrigeração líquida direta ao chip para lidar com as crescentes demandas térmicas das GPUs mais recentes e desbloquear todos os recursos de desempenho dos processadores NVIDIA. Tecnologia Blackwell.

Os novos sistemas otimizados para GPU da Supermicro estarão disponíveis em breve, totalmente compatíveis com as GPUs NVIDIA Blackwell B200 e B100 Tensor Core e certificados para o mais recente software NVIDIA AI Enterprise. A linha da Supermicro inclui diversas configurações, desde sistemas NVIDIA HGX B100 e B200 de 8 GPUs até SuperBlades capazes de acomodar até 20 GPUs B100, garantindo versatilidade e alto desempenho em uma ampla gama de aplicações de IA. Esses sistemas incluem os primeiros modelos NVIDIA HGX B200 e B100 de 8 GPUs do mercado com tecnologia avançada de interconexão NVIDIA NVLink. A Supermicro indica que está preparada para fornecer resultados de treinamento para LLMs (3x mais rápido) e oferecer suporte a clustering escalonável para cargas de trabalho exigentes de IA, marcando um salto significativo na eficiência e no desempenho computacional da IA.

Tecnologia de resfriamento líquido Supermicro

Envolva-se com a StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed