Der Augmented Memory von WEKA für KI-Inferenz steigert die GPU-Effizienz, reduziert Latenz und Kosten und skaliert gleichzeitig KI-Modelle für Unternehmens-Workloads.

WEKA hat seine strategische Integration mit dem Referenzdesign der NVIDIA AI Data Platform bekannt gegeben. Das Unternehmen erhielt wichtige NVIDIA-Speicherzertifizierungen, um eine optimierte Infrastruktur bereitzustellen, die speziell auf agentenbasierte KI und komplexe Schlussfolgerungsmodelle zugeschnitten ist. Parallel dazu stellte WEKA seine innovative Augmented Memory Grid-Funktion und zusätzliche Zertifizierungen für NVIDIA Cloud Partner (NCP)-Referenzarchitekturen vor, darunter NVIDIA GB200 NVL72 und NVIDIA-Certified Systems Storage für KI-Fabrikimplementierungen im Unternehmensmaßstab.

Beschleunigung von KI-Agenten

Die NVIDIA AI Data Platform stellt einen bedeutenden Fortschritt in der KI-Infrastruktur von Unternehmen dar und integriert nahtlos die NVIDIA Blackwell-Architektur, NVIDIA BlueField DPUs, Spectrum-X-Netzwerke und die NVIDIA AI Enterprise-Software. Durch die Kombination dieser fortschrittlichen NVIDIA-Infrastruktur mit der WEKA Data Platform können Unternehmen eine massiv skalierbare Speicherbasis bereitstellen, die speziell für hochleistungsfähige KI-Inferenz-Workloads entwickelt wurde.

Diese integrierte Lösung adressiert direkt die wachsenden Anforderungen an Enterprise-KI und bietet KI-Abfrageagenten einen nahtlosen, beschleunigten Zugriff auf kritische Geschäftsinformationen. Dies führt zu einer deutlich verbesserten Inferenzleistung und Argumentationsgenauigkeit. Die Datenplattform von WEKA stellt sicher, dass KI-Systeme Daten schnell in verwertbare Informationen umwandeln und so das anspruchsvolle Denken unterstützen, das KI-Modelle der nächsten Generation benötigen.

WEKA Erweitertes Speicherraster

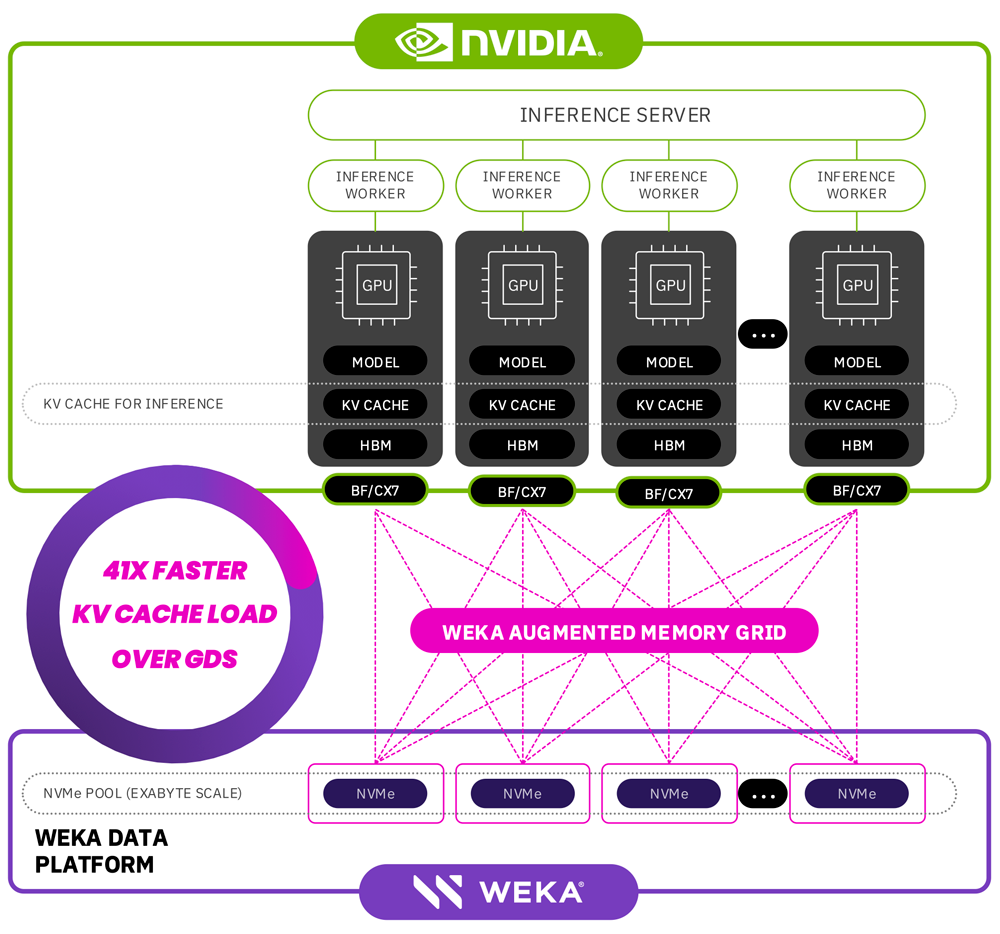

Agentische KI-Modelle entwickeln sich kontinuierlich weiter und können größere Kontextfenster, umfangreiche Parameterzahlen und einen höheren Speicherbedarf bewältigen. Diese Fortschritte stoßen oft an die Grenzen herkömmlicher GPU-Speicherkapazitäten und führen zu Engpässen bei der KI-Inferenz. WEKA begegnet diesen Herausforderungen mit seiner bahnbrechenden Augmented Memory Grid-Lösung. Diese Innovation erweitert den verfügbaren Speicher für KI-Workloads und ermöglicht Petabyte-Schritte – weit über die aktuellen Ein-Terabyte-Begrenzungen hinaus.

Das Augmented Memory Grid von WEKA verbessert die KI-Inferenz erheblich, indem es die Datenplattform-Software von WEKA mit den beschleunigten Rechen- und Netzwerktechnologien von NVIDIA kombiniert. Diese Kombination ermöglicht einen Zugriff mit nahezu Speichergeschwindigkeit und einer Latenzzeit von Mikrosekunden, was die Token-Verarbeitungsleistung und die allgemeine Effizienz der KI-Inferenz deutlich verbessert.

Zu den wichtigsten Vorteilen des Augmented Memory Grid von WEKA gehören:

-

Deutlich reduzierte Latenz: In Tests mit 105,000 Token lieferte das Augmented Memory Grid von WEKA eine bemerkenswerte 41-fache Verbesserung der Zeit bis zum ersten Token im Vergleich zu herkömmlichen Neuberechnungsmethoden.

-

Optimierter Token-Durchsatz: Die Lösung von WEKA verarbeitet Inferenz-Workloads effizient über Cluster hinweg und erreicht einen höheren Token-Durchsatz bei geringeren Gesamtkosten. Dadurch werden die Kosten pro verarbeitetem Token systemweit um bis zu 24 % gesenkt.

Diese Leistungssteigerungen führen direkt zu einer verbesserten wirtschaftlichen Effizienz und ermöglichen es Unternehmen, KI-gesteuerte Innovationen zu beschleunigen, ohne die Modellfunktionen oder die Infrastrukturleistung zu beeinträchtigen.

WEKApod Nitro

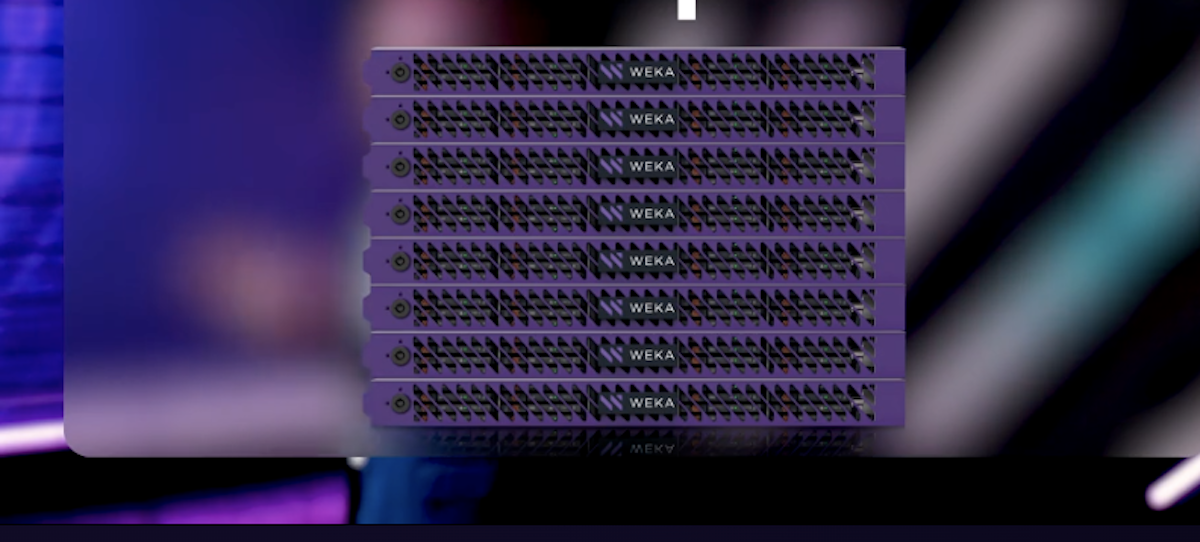

WEKApod Nitro Data Platform-Geräte haben mehrere NVIDIA-Zertifizierungen erhalten, wodurch sich WEKA als führender Anbieter von Hochleistungsspeichern für Unternehmens-KI etabliert hat:

-

NVIDIA Cloud Partner (NCP)-ZertifizierungWEKApod Nitro gehört zu den ersten Speicherlösungen, die für NVIDIAs NCP-Referenzarchitekturen zertifiziert sind, darunter HGX H200, B200 und GB200 NVL72. Diese Geräte unterstützen Dienstanbieter und Entwickler durch die Unterstützung massiver GPU-Cluster – bis zu 1,152 GPUs in einer 8-HE-Konfiguration – und bieten gleichzeitig eine außergewöhnliche Leistungsdichte und Energieeffizienz.

-

NVIDIA-zertifizierte SystemspeicherbezeichnungWEKApod Nitro-Geräte haben die neue Enterprise-Storage-Zertifizierung von NVIDIA erhalten. Diese Zertifizierung gewährleistet die Kompatibilität mit NVIDIA Enterprise-Referenzarchitekturen und Best Practices. Diese Auszeichnung bestätigt, dass die WEKA-Datenplattform optimale Speicherleistung, Effizienz und Skalierbarkeit für anspruchsvolle KI- und HPC-Implementierungen in Unternehmen bietet.

Nilesh Patel, Chief Product Officer von WEKA, betonte das transformative Potenzial dieser Partnerschaft mit NVIDIA. Patel verglich diese Entwicklung mit Durchbrüchen in der Luft- und Raumfahrt und erklärte: „So wie das Durchbrechen der Schallmauer neue Grenzen erschlossen hat, durchbricht WEKAs Augmented Memory Grid die KI-Speicherbarriere, erweitert den GPU-Speicher drastisch und optimiert die Token-Effizienz. Diese Innovation verändert die KI-Token-Ökonomie grundlegend und ermöglicht schnellere Innovationen und niedrigere Kosten ohne Leistungseinbußen.“

Rob Davis, Vice President of Storage Networking Technology bei NVIDIA, betonte die Bedeutung dieser Integration: „Unternehmen, die agentenbasierte KI und Reasoning-Modelle einsetzen, benötigen beispiellose Effizienz und Skalierbarkeit. Die Kombination von NVIDIA- und WEKA-Technologien stellt sicher, dass KI-Agenten während der Inferenz mit unübertroffener Geschwindigkeit und Genauigkeit auf Daten zugreifen und diese verarbeiten können.“

Verfügbarkeit

- Die NCP-Referenzarchitektur von WEKA für NVIDIA Blackwell-Systeme wird im März verfügbar sein.

- Die WEKA Augmented Memory Grid-Funktion wird für Kunden der WEKA Data Platform im Frühjahr 2025 allgemein verfügbar sein.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed