IBM 将在 IBM Cloud 上添加 AMD Instinct MI300X 加速器作为服务,以增强 GenAI 模型的性能和能源效率。

IBM 宣布扩大与 AMD 的合作,在 IBM Cloud 上推出 AMD Instinct MI300X 加速器服务。该解决方案可提高生成式人工智能 (GenAI) 模型和高性能计算 (HPC) 应用程序的性能和能效,满足企业客户对可扩展人工智能解决方案日益增长的需求。

该合作伙伴关系将支持 AMD Instinct MI300X 加速器 涵盖 IBM 的 AI 和数据生态系统,包括用于 AI 推理的 Watson X AI 平台和 Red Hat® Enterprise Linux®。这与 IBM Cloud 现有的产品组合相一致,该产品组合已经具有 英特尔高迪3 加速器和扩展器 NVIDIA H100 张量核心 GPU 实例,进一步增强其提供高性能 AI 和 HPC 工作负载的能力。

AMD Instinct MI300X 加速器的高级功能

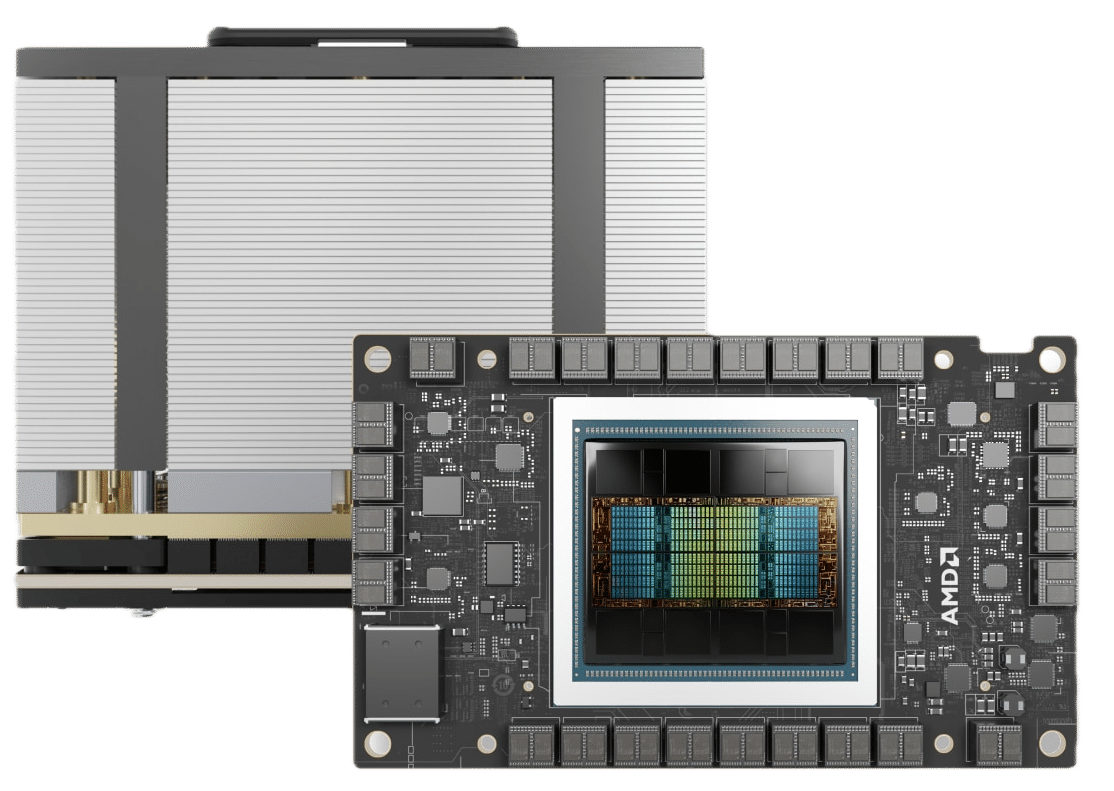

AMD Instinct MI300X 加速器配备 192GB 高带宽内存 (HBM3),旨在支持企业 AI 应用程序的大型模型推理和微调。其高内存容量使企业能够使用更少的 GPU 运行更大的 AI 模型,从而降低成本,同时保持性能和可扩展性。我们最近在我们的 XE9680 评测.

通过在 IBM Cloud Virtual Servers for VPC 上以及通过 IBM Cloud Kubernetes Service 和 IBM Red Hat OpenShift 等容器化解决方案提供这些加速器作为服务,IBM 旨在为企业客户提供针对其 AI 工作负载优化的安全、高性能环境。这种灵活性使组织能够高效地扩展其 AI 部署,同时保持强大的安全性和合规性——这对于受到严格监管的行业的客户尤其重要。

与 IBM Watson X 和 Red Hat 平台集成

为了满足生成式 AI 推理工作负载的需求,IBM 计划将 AMD Instinct MI300X 加速器与其 watsonx AI 平台集成。这将为 watsonx 客户配备额外的 AI 基础架构资源,使他们能够在混合云环境中无缝扩展工作负载。加速器还将支持 Red Hat Enterprise Linux AI 和 Red Hat OpenShift AI 平台,使企业能够部署 Granite 系列等大型语言模型 (LLM) 和 InstructLab 等高级对齐工具。

这些集成强调了加速器以更大的灵活性处理计算密集型工作负载的能力,使企业能够在 AI 部署中优先考虑性能、成本效率和可扩展性。

AMD 执行副总裁兼首席商务官 Philip Guido 强调了性能和灵活性在处理计算密集型工作负载方面的重要性,尤其是在企业采用更大的 AI 模型时。他指出,AMD Instinct 加速器与 AMD ROCm 软件相结合,为 IBM watsonx AI 和 Red Hat OpenShift AI 等平台提供了广泛的生态系统支持,使客户能够在不影响效率或成本的情况下执行和扩展 GenAI 推理。

IBM Cloud 总经理 Alan Peacock 也表达了同样的看法,他强调 AMD 和 IBM 的共同愿景是将 AI 解决方案带入企业。他表示,在 IBM Cloud 上利用 AMD 加速器可以为企业客户提供可扩展、经济高效的选项,以满足他们的 AI 目标,而 IBM 也致力于提供安全、合规和以结果为导向的解决方案。

协作带来增强的安全性和合规性

此次合作充分利用了 IBM Cloud 知名的安全性和合规性功能,确保企业(包括那些监管严格的行业)能够放心采用由 AMD 加速器提供支持的 AI 基础架构。这种对安全性的承诺是 IBM 和 AMD 支持企业大规模采用 AI 的战略不可或缺的一部分。

通过此次合作,IBM 和 AMD 为企业提供了兼顾性能、可扩展性和效率的尖端 AI 基础架构。IBM Cloud 中新增的 AMD Instinct MI300X 加速器有望满足企业 AI 工作负载日益增长的需求,使组织能够在 AI 和 HPC 应用中释放新的可能性。

可用性

搭载 AMD Instinct MI300X 加速器的 IBM Cloud 服务预计将于 2025 年上半年全面上市,进一步扩展 IBM 的高性能 AI 和 HPC 解决方案产品组合。

参与 StorageReview

电子报 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | TikTok | RSS订阅